Ошибки на сайте влияют на то, как поисковики воспринимают и ранжируют страницы ресурса. Позиции сайта могут проседать в выдаче, а чтобы определить причину проблемы, нужно проводить аудиты. Полноценный SEO-аудит отнимает много сил и времени, поэтому часто его делегируют специалистам по аудитам, но обычно и поверхностная самостоятельная проверка позволяет найти главные ошибки.

Такую проверку любой страницы на сайте можно провести буквально за 15 минут, затрагивая и технические факторы, и оптимизацию. Ускорить процесс поможет сервис автоматического аудита « Анализ сайта», который проверяет и главную, и внутренние страницы.

Быстрый SEO-аудит за пять шагов:

- Проверьте индексацию в SERP.

- Проверьте сайт на штрафы и санкции.

- Найдите скрытый текст.

- Оцените скорость загрузки.

- Проанализируйте оптимизацию.

Советуем выбрать для аудита несколько разных страниц, которые важны с точки зрения трафика и содержания. Это нужно для того, чтобы не пропустить ошибки, которых будут на других страницах, если вы проверите только одну. Возьмите, к примеру, карточку товара, страницу из блога и страницу товарной категории.

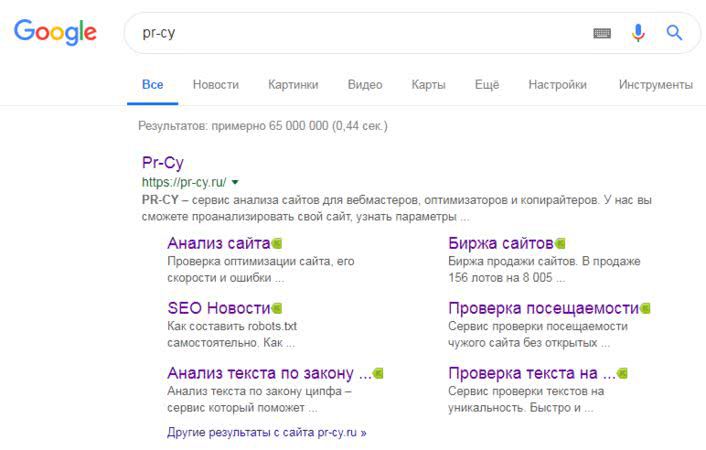

1. Проверьте индексацию в SERP

Проверьте, как проиндексирован домен в поисковых системах: введите название своей компании и посмотрите, есть ли сайт в результатах. Обратите внимание на то, как выглядит сниппет сайта, насколько он привлекателен для пользователей. У него должен быть понятный заголовок, релевантное описание, которое бы объясняло, что за сайт и чем он полезен.

Компания в выдаче Google

Через поиск можно оценить примерное число страниц, которое проиндексировано в поисковой системе. Для этого в строку поиска введите «site:вашсайт.ру» и посмотрите на количество результатов.

Сайт в Google

Проверить индексацию через строку поиска — быстрый способ, более детально изучить индексацию ресурса ботом можно в разделе «Состояние индекса» в Google Search Console.

Количество страниц в выдаче — это только те страницы, которые попали в индекс. Фактический размер сайта всегда больше, он складывается из всех страниц, которые генерирует движок, в том числе и неиндексируемых. В крупных интернет-магазинах с большим количеством товаров размер сайта может доходить и до миллиона страниц. У больших сайтов сложно посчитать размер, поэтому число страниц определяют с помощью анализа лог-файлов.

Зачем нужно смотреть на количество страниц в индексе:

если поисковик показывает слишком маленькое число, вероятно, часть страниц скрыта от индексации, ее почему-то игнорирует бот-краулер. Среди таких страниц могут оказаться и важные для бизнеса. Если число кажется подозрительным, проверьте лог-файлы — анализ лог файлов сервера покажет, как распределяется краулинговый бюджет.

Если краулеры заняты сканированием неважных страниц, а целевые обходят стороной, направьте их с помощью файла robots.txt — укажите в нем, какие страницы ботам стоит сканировать, а какие посещать не нужно. Составьте для них указания с помощью карты сайта — Sitemap, и укажите ссылку на нее в файле robots.txt.

Важными боты считают страницы, до которых можно добраться за минимальное количество кликов с главной, их сканируют в первую очередь после главной. Направить ботов на важные с точки зрения бизнеса страницы поможет внутренняя перелинковка.

Если вы считаете, что бот работает слишком медленно, то скорость обработки страниц краулером от Google можно увеличить. Джон Мюллер советует обратиться в справочный центр Google для веб-мастеров и запросить более высокую скорость сканирования для своего сайта, если понимаете, что сервер вашего хостинга имеет большую емкость.

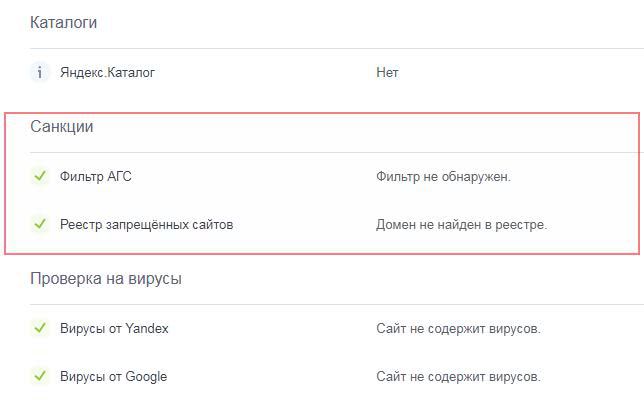

2. Проверьте сайт на штрафы и санкции

Обычно поисковики уведомляют веб-мастеров, когда накладывают на сайт санкции за нарушения, но так бывает не всегда. Санкции могут не повлечь значительного снижения органического трафика, владелец сайта не заметит изменений и не заподозрит, что сайт под фильтром Google или Яндекса. На всякий случай лучше убедиться, что сайт свободен от санкций.

Сообщения от Яндекса о нарушениях будут в Яндекс.Вебмастер, зайдите в раздел «Диагностика» — «Безопасность и нарушения». От Google в Search Console в разделе «Поисковый трафик» — «Меры, принятые вручную».

Если никаких уведомлений нет, но странное снижение органического трафика есть, запросите у поддержки информацию о санкциях или проверьте сайт сторонними инструментами.

Быстро узнать, не попал ли ресурс в реестр запрещенных сайтов или фильтр, можно с помощью Анализа сайтов от PR-CY. Проверка по этим параметрам есть в разделе «Поисковые системы»:

Раздел с санкциями в инструменте

Роскомнадзор уведомляет о нарушении за три дня до блокировки, но в случае, если на сайте была обнаружена детская порнография, пропаганда наркотиков или суицида, то сайт блокируют без предупреждения. На официальном сайте Роскомнадзора можно проверить, попал ли ресурс в реестр запрещенных.

Инструмент «Проверка блокировки сайта Роскомнадзором» проверит домен и IP на запрет РКН.

Проверка домена и IP на блокировку от РКН

О причинах блокировок ФАС, РКН и других федеральных служб подробнее в статье «Как не получить штраф за сайт?»

Что делать, если обнаружили санкции и фильтры:

действия веб-мастера зависят от типа фильтра, обычно поисковики называют причину. Если дело в переспаме в текстах, нужно переписать контент и сделать текст естественным, если в большом количестве баннеров, то убрать баннеры, если поисковик наказал за купленные ссылки, то снять их.

Если сайт получил блокировку от Роскомнадзора, и вы считаете ее несправедливой, за консультацией можно обратиться в организации, которые помогают оспаривать решения — к примеру, в « Роскомсвободу».

3. Найдите скрытый текст

Некоторые оптимизаторы используют приемы «черного SEO», чтобы повлиять на ранжирование. Добавляют на страницу ключевые слова с помощью скрытого текста, который не могут прочесть пользователи, но воспринимают и учитывают поисковики. Обычно скрывают текст так: делают его нечитаемого кегеля или одинакового цвета с фоном, помещают за пределы экрана с помощью CSS или другими способами.

Скрыть текст с целью повлиять на рейтинг — это нарушение правил поисковиков, за него последуют санкции. Яндекс наказывает исключением страниц из поиска, Google тоже применяет ручные меры. Если вы использовали такой метод, но попали под санкции, удалите скрытый текст или сделайте его видимым и запустите проверку через систему для Вебмастеров.

Скрытый текст применяют не только для черных методов продвижения, но и для того, чтобы сделать ресурс удобнее и понятнее пользователям и поисковикам, которые могут видеть сайт по-разному из-за реализованных стилей CSS или элементов JavaScript.

Веб-мастеры рекомендуют добавить скрытое текстовое описание к элементам JavaScript и изображениям. Дублируйте содержание JavaScript в теге <noscript>, а для изображений используйте естественное описание с ключами в теге "alt". Описания помогут ориентироваться на сайте пользователям, которые не могут загрузить изображения и плагины, и подскажут поисковикам, по каким ключам ранжировать изображения. От Flash лучше отказаться — эти элементы создают брешь в безопасности сайта и могут не поддерживаться у пользователей.

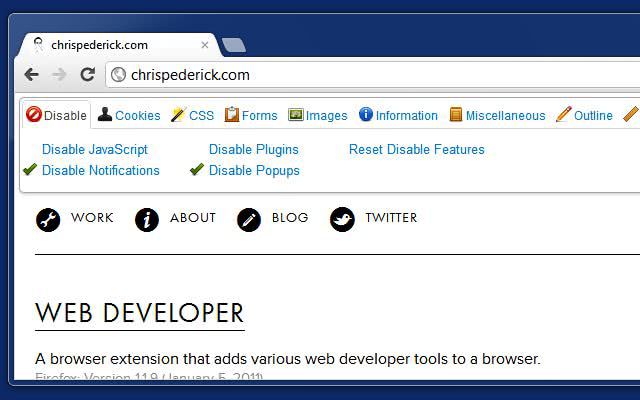

Проверьте, как видят страницу пользователи, которые смотрят сайт в режиме с отключенными плагинами, и как ее воспринимают поисковики. Найти скрытый текст поможет отключение элементов JavaScript, стилей CSS и изображений.

Отключить CSS и JS можно с помощью браузерного расширения Web Developer, если вы пользуетесь Google Chrome.

Расширение Web Developer для работы с CSS и JS

Отключите элементы, перезагрузите страницу и сравните содержимое: проверьте, не виден ли текст, который должен быть скрытым, и наоборот. Скрытые элементы CSS веб-мастера обычно рекомендуют удалить или отредактировать, чтобы сайт отображался корректно на всех устройствах и браузерах.

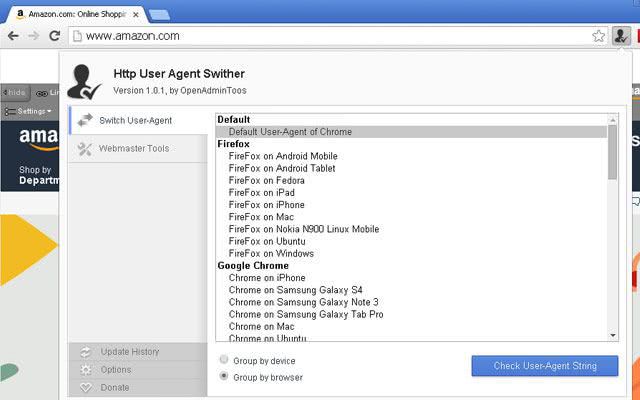

Посмотреть, как выглядит страница на разных устройствах, можно с помощью расширения « HTTP User Agent Switcher» для Google Chrome. Расширение также покажет, как мобильную и десктопную страницу видит Googlebot.

Настройка Agent Switcher

Джон Мюллер утверждает, что краулер Google обрабатывает Javascript только во время второй волны рендеринга и индексирования, поэтому не нужно дублировать сигналы в HTML и Javascript, если вы изменяете теги через Javascript или хотите отключить индексирование страницы.

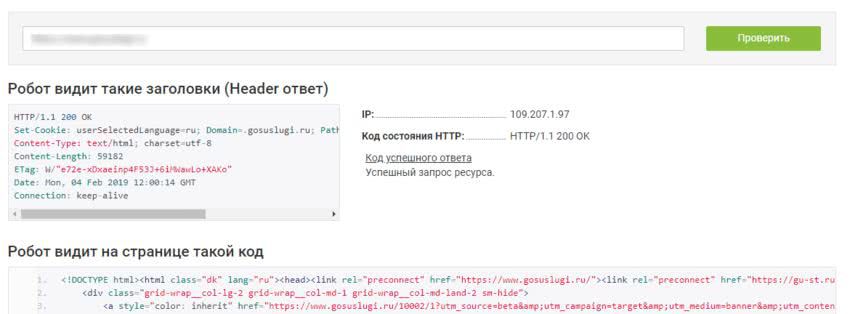

Проверьте, как боты воспринимают страницу и какой видят текст. Бесплатно посмотреть на сайт глазами поискового робота поможет инструмент:

Пример анализа инструментом

Пример анализа инструментом

Кроме того, он считает количество внутренних и внешних ссылок, и определяет, какие из них индексируются поисковиками.

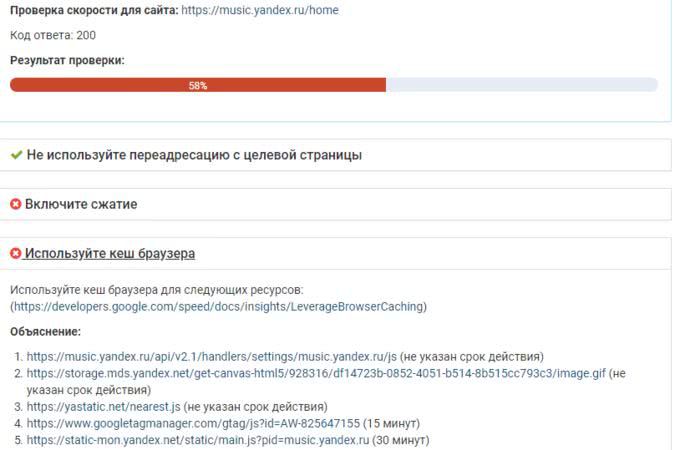

4. Оцените скорость загрузки

Скорость загрузки — один из факторов ранжирования в Яндекс и Google, кроме того она влияет на поведенческие факторы: многие пользователи не будут ждать загрузки, закроют сайт и показатель отказов вырастет.

Поисковики анализируют скорость загрузки в целом: учитывают рендеринг, время загрузки первого байта — TTFB, время ответа сервера. Ускорить загрузку поможет оптимизация кода верхней части страницы, чтобы пользователь мог быстрее приступить к изучению контента, как только перешел по ссылке. Уменьшайте размер страниц, чтобы они быстрее загружались у пользователей с медленным интернетом или с мобильных устройств.

Оценить скорость загрузки можно инструментом « Проверка скорости сайта» от PR-CY. Он ориентируется на критерии, которых придерживаются поисковики при оценке, и дает пояснения.

Анализ скорости загрузки сайта

Анализ скорости загрузки сайта

Томаш Рудзки в своем руководстве по Javascript рекомендует удостовериться, что на загрузку и обработку файлов JavaScript тратится меньше пяти секунд. Он утверждает, что элементы, которые загружаются позднее, поисковик может игнорировать.

5. Проанализируйте оптимизацию

Кроме пунктов из предыдущих разделов, в рамках быстрого самостоятельного SEO-аудита нужно сосредоточиться на самых важных элементах оптимизации, которые могут повлиять на отношение поисковиков и органический трафик.

Проверить оптимизацию страницы:

- Title .

Релевантный заголовок с ключом, отображается в сниппете выдачи и на вкладке, не дублируется. Рекомендуемый размер — 70-80 знаков. - H1 заголовок.

Релевантный заголовок страницы с ключом, должен быть в единственном варианте. - H2-H3 заголовки.

Содержат релевантные ключи, раскрывают тему. - Descriptions.

Описание, используется в сниппете, содержит ключи и поясняет содержимое. - Редиректы .

Не используйте тег "meta refresh", а также не рекомендуют использовать ссылки с 301 редиректом, поскольку Google может не проиндексировать конечный URL. - Сканирование страниц и индексация.

Важные страницы открыты для индексации в robots.txt и указаны в карте сайта. - Внутренняя перелинковка.

Важные страницы имею минимальный уровень вложенности, перелинкованы с главной и другими авторитетными страницами сайта. - Высокая скорость загрузки.

Сервер быстро обрабатывает запрос, все JS-элементы и стили загружаются в течение 5 секунд, пользователь видит загрузку уже спустя пару секунд после перехода. - Корректная кодировка.

Кодировка, которую отправляет сервер, совпадает с кодировкой сайта. Информация о ней есть в строке "Content-Type: text/html; charset=utf-8" ответа сервера, где "utf-8" — указание кодировки. В исходном коде страницы должна быть такая же: <meta http-equiv="Content-Type" content="text/html; charset=UTF-8">. Укажите эту строку в шаблоне сайте в теге "head".

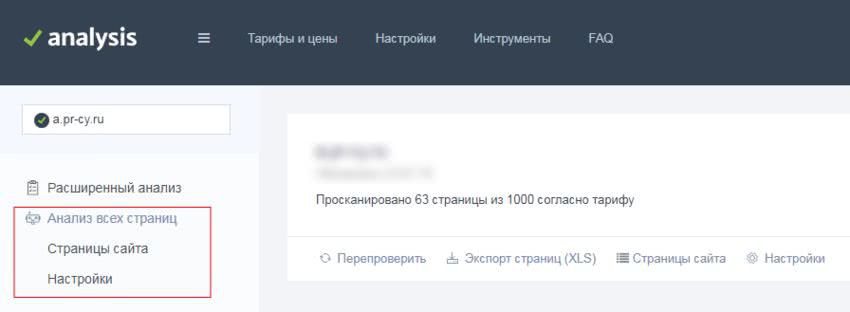

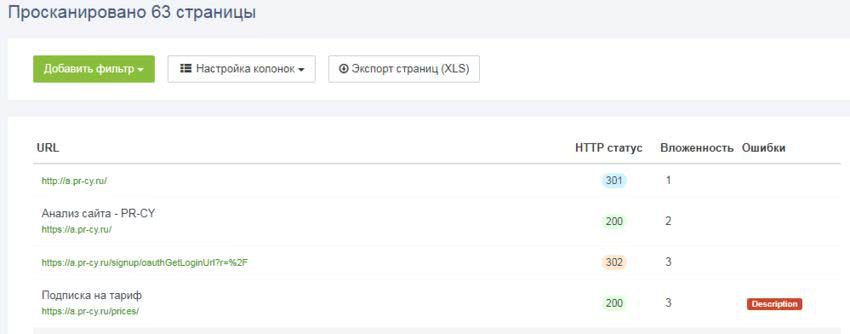

Вы можете проверить эти пункты вручную, но для экономии времени можно использовать автоматический инструмент. Сервис «Анализ сайта» от PR-CY умеет анализировать внутренние страницы ресурса по самым важным параметрам.

Раздел с анализом внутренних страниц сайта находится в левом меню под Расширенным анализом. В настройках есть режимы анализа с задержкой между запросами, с учетом robots.txt и без него.

Анализ всех страниц

Анализ всех страниц

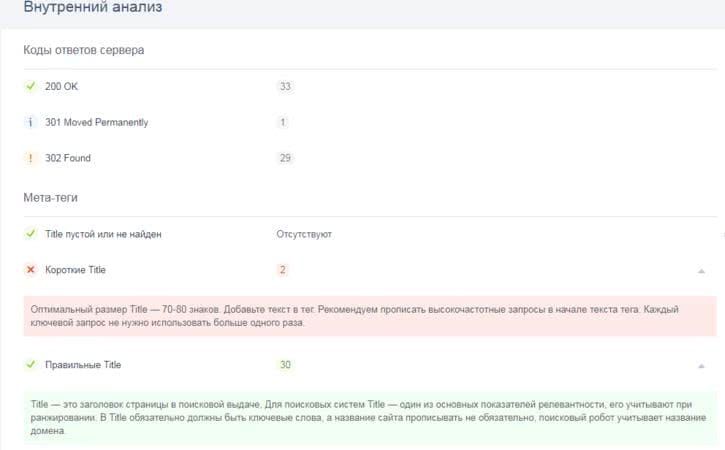

Сервис оценивает коды ответов сервера, мета-теги, оптимизацию контента и технические характеристики, дает пояснения и советы к каждому пункту.

Фрагмент анализа внутренних страниц

Фрагмент анализа внутренних страниц

Сервис проанализирует страницы пакетом в указанном количестве и отдельно покажет статистику с выбранными фильтрами по каждой.

Фрагмент анализа по каждой странице

Фрагмент анализа по каждой странице

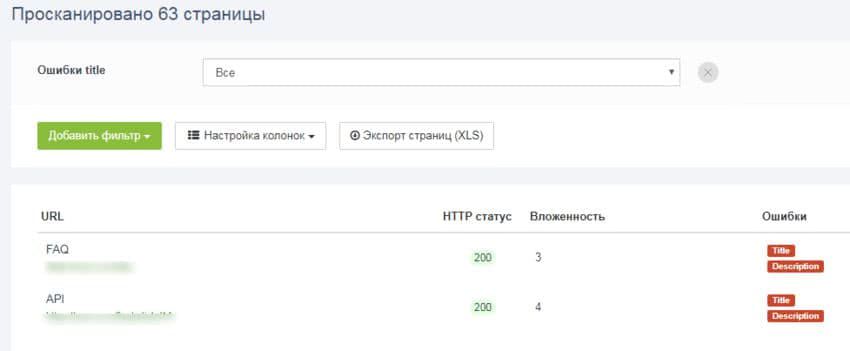

Вы можете установить нужные фильтры из обширного списка и найти те страницы, в которых есть, к примеру, неуникальный Title или Description с конкретным ключом.

Фрагмент анализа с фильтром

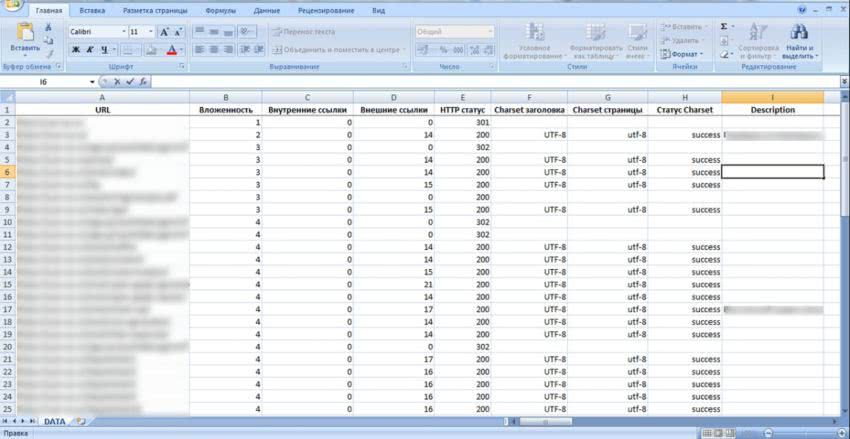

Результаты можно скачать в табличке формата XLS, в ней будет сборная информация по каждой странице.

Фрагмент анализа в таблице XLS

После всех этапов быстрого аудита у вас будет список главных ошибок, которые влияют на органический трафик и сканирование сайта поисковиками.

Анализ множества страниц позволит выявить массу реальных проблем, которые мешают получать больше трафика и занимать более высокие места в поисковых системах. Причем выявить главные проблемы можно за несколько минут, их исправление уже намного улучшит состояние ресурса. А с помощью автоматических инструментов это будет еще проще и быстрее выполнить.